Umarł król, niech żyje król! Jednym z najpopularniejszych modeli kierowanych do małych i średnich przedsiębiorstw, które potrzebowały małych, dwu- i czterodyskowych urządzeń były QNAPy z serii TS-x53A, czyli odpowiednio modele TS-253A oraz TS-453A. Producent oficjalnie zaprezentował ich następców, czyli TS-253Be i TS-453Be.

Te dwa modele cieszyły się dużym zainteresowaniem z kilku powodów. Przede wszystkim w atrakcyjnej cenie oferowały niezłą wydajność oraz obsługę wszystkich funkcji dostępnych w systemie QTS, w tym wirtualizacji. Model ten miał dużo portów, m.in. 2 porty HDMI pozwalające na podłączenie 2 ekranów zewnętrznych w rozdzielczości do 4K 2160P 30Hz Ultra HD czy wyjście audio.

Dodatkowo model czterodyskowy, czyli TS-453a posiadał duży wyświetlacz LCD informujący o statusie urządzenia.

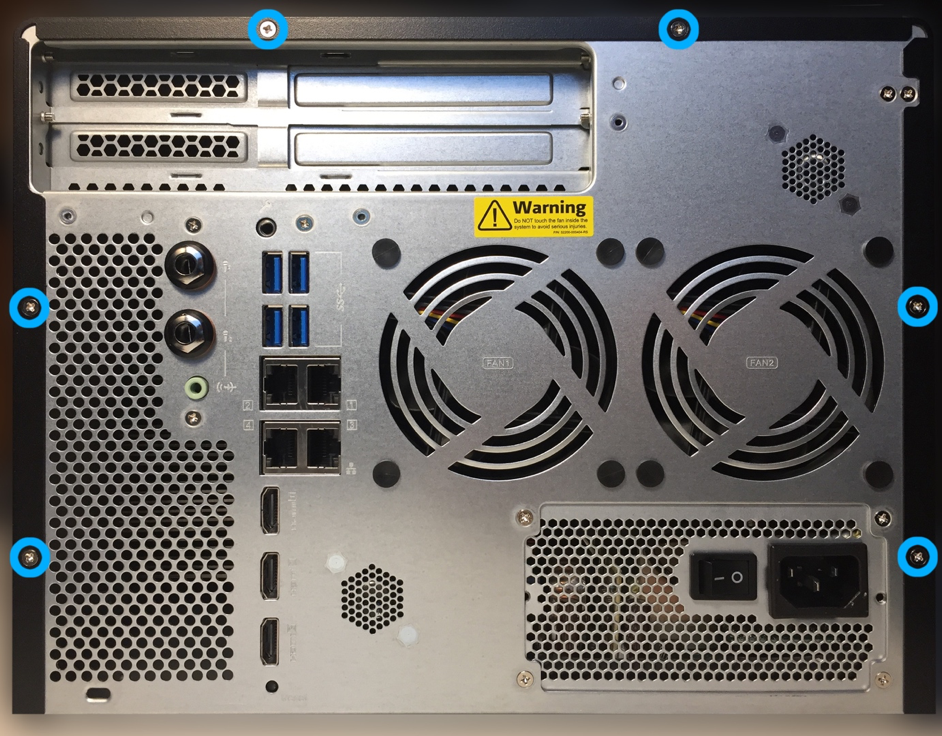

Oczywiście jedną z najbardziej rzucających się w oczy rzeczy w budowie tego QNAP’a były dwa spore otwory z tyłu – były to gniazda line-in na dwa mikrofony, które można było wykorzystać z aplikacją OceanKTV Station, czyli aplikacją do… Karaoke. Sama opcja była na naszym rodzimym rynku mało popularna, ale warto wiedzieć. Ot, ciekawostka.

Samo urządzenie przez dłuższy czas dzielnie radziło sobie na rynku, jednak producent podjął decyzję o zakończeniu jego produkcji.

Wróćmy więc do tytułu. Produkcja modelu została zakończona, jednak producent zaproponował jego zastępstwo – serię TS-x53Be. Warto tutaj wyjaśnić kwestię nazewnictwa. Ogólnie w nazwach modeli QNAP dwie ostatnie cyfry oznaczają serię. Im wyższy numer, tym wyższa seria, a co za tym idzie, mocniejsze urządzenia.

Przykładowo mamy serie TS-x28a, TS-x51+, TS-x53Be czy TVS-x77. „X” z kolei oznacza liczbę zatok. Tak więc w serii TS-x53Be mamy modele z „2” i „4”, czyli dwu- i czterozatokowe urządzenia. Oczywiście w ramach danej serii, wszystkie urządzenia, bez względu na liczbę zatok mają taką samą lub bardzo zbliżoną specyfikację sprzętową (różnica to np. liczba interfejsów sieciowych).

TS-253Be, TS-453Be

Nowa seria to przede wszystkim odświeżony wygląd. Wcześniejsze metalowe obudowy zostały zastąpione plastikowymi. Może to u części użytkowników budzić wątpliwości co do trwałości, jednak materiały użyte do jej wykonania są dobrej jakości, plastik jest stosunkowo gruby, nie skrzypi, nie trzeszczy i jest dobrze dopasowany. Dlatego pod kątem wykonania nie ma się do czego przyczepić.

Dodatkową zmianą jest też rezygnacja z metalowych tacek na dyski – podobnie jak obudowa są plastikowe, jednak i tutaj nie ma zastrzeżeń co do jakości i wykonania. Plusem jest też system szybkiego montażu dysków – nie potrzebujemy do tego narzędzi, gdyż tacki są wyposażone w plastikowe blokady do dysków. Podsumowując – pod kątem budowy i wykonania urządzenie wypada bardzo dobrze, szczególnie, gdy musi stać na biurku lub w innym widocznym miejscu.

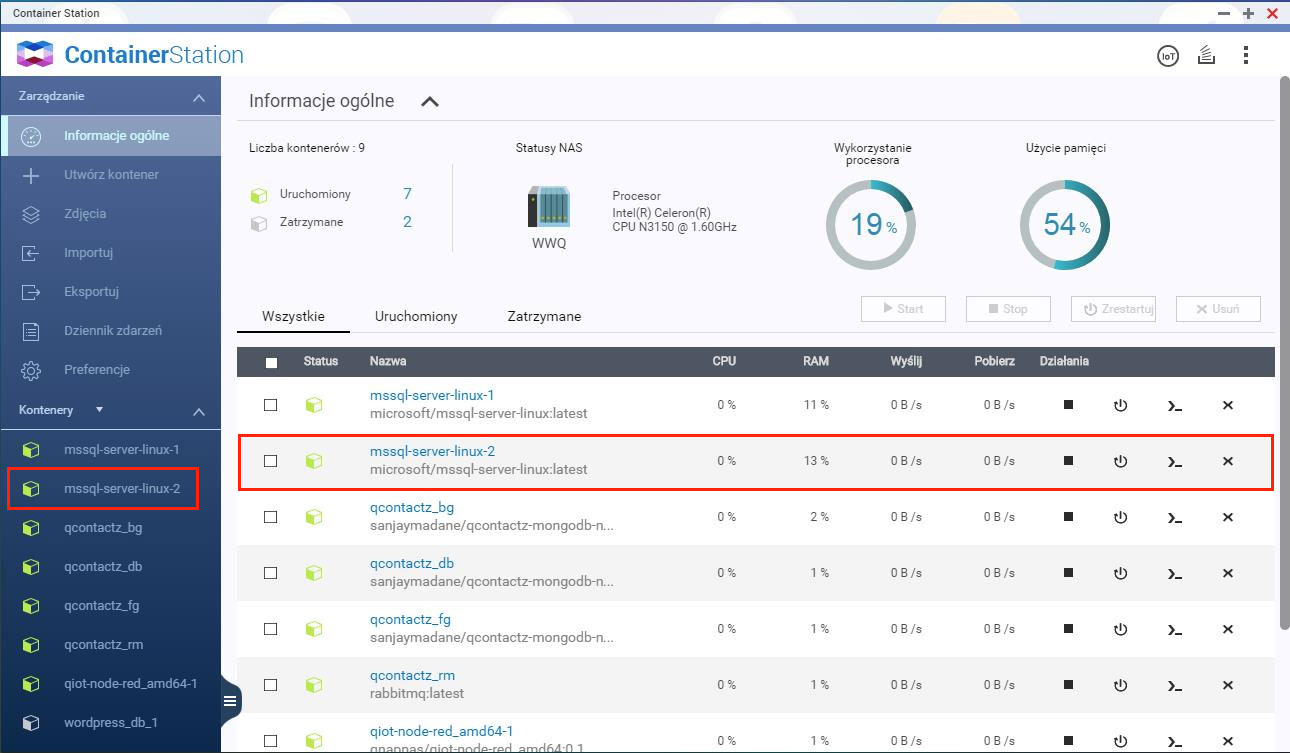

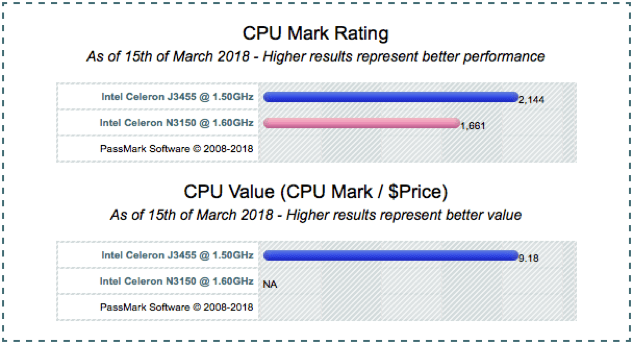

Kolejna zmiana pomiędzy starszą a nową serią to procesor. Modele TS-x53A wykorzystywały czterordzeniowe procesory Intel Celeron N3150 @ 1.60GHz, z kolei seria TS-x53Be jest już wyposażona w Intel Celeron J3455 @ 1.50GHz. Oczywiście na pierwszy rzut oka widać, że nowy model ma procesor o niższym taktowaniu, jednak nie powinno to nikogo zmylić, bo są one dużo wydajniejsze (porównanie można zobaczyć np. tutaj: https://www.cpubenchmark.net/compare.php?cmp[]=2875&cmp[]=2546)

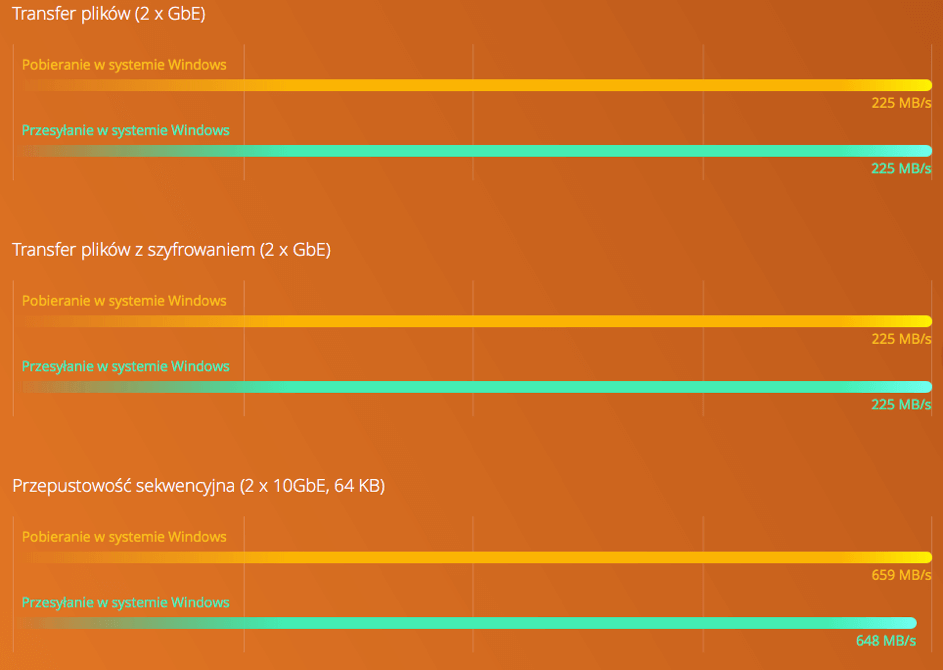

Model dodatkowo obsługuje szyfrowanie Intel AES-NI z akceleracją sprzętową, dzięki czemu przy 256-bitowemu szyfrowaniu woluminów lub folderów, transfer mogą dochodzić nawet do 225MB/s. Dla porównania, w przypadku braku szyfrowania, transfery osiągają takie same wartości, a więc nie ma obaw, że zwiększenie bezpieczeństwa przechowywanych danych będzie wiązało się z utratą wydajności.

Testy przeprowadzono w laboratoriach QNAP. Wyniki mogą się różnić w zależności od środowiska.

Środowisko testowe:

NAS:

System operacyjny: QTS 4.3.3

Wolumin: RAID 5; 4 dyski SSD Intel S3500 240 GB (SSDSC2BB240G4); 2 porty QNAP LAN-10G2SF-MLX 10GbE SFP+

Komputer kliencki:

Procesor Intel® Core™ i7-4770 3,40 GHz; pamięć DDR3L 1600 Hz 16 GB; WD 1TB WD10EZEX; Intel Gigabit CT (MTU 1500); Windows® 10 64-bitowy

Kolejna zmiana to wielkość pamięci RAM – wcześniej modele występowały w wersjach 4GB i 8GB, teraz mamy 2GB lub 4GB. Oczywiście wciąż można RAM rozszerzyć, i tutaj zmian nie ma, maksymalna ilość to 8GB, przy czym modele serii Be obsługują już pamięci taktowane 1866 MHz.

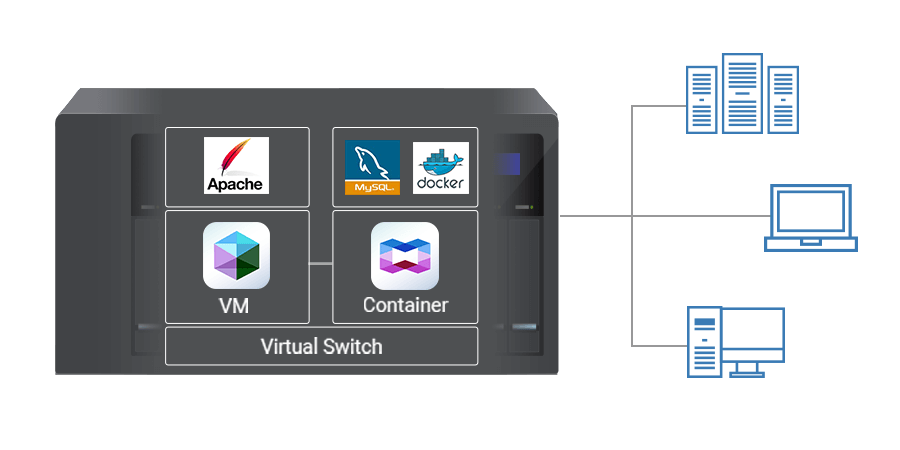

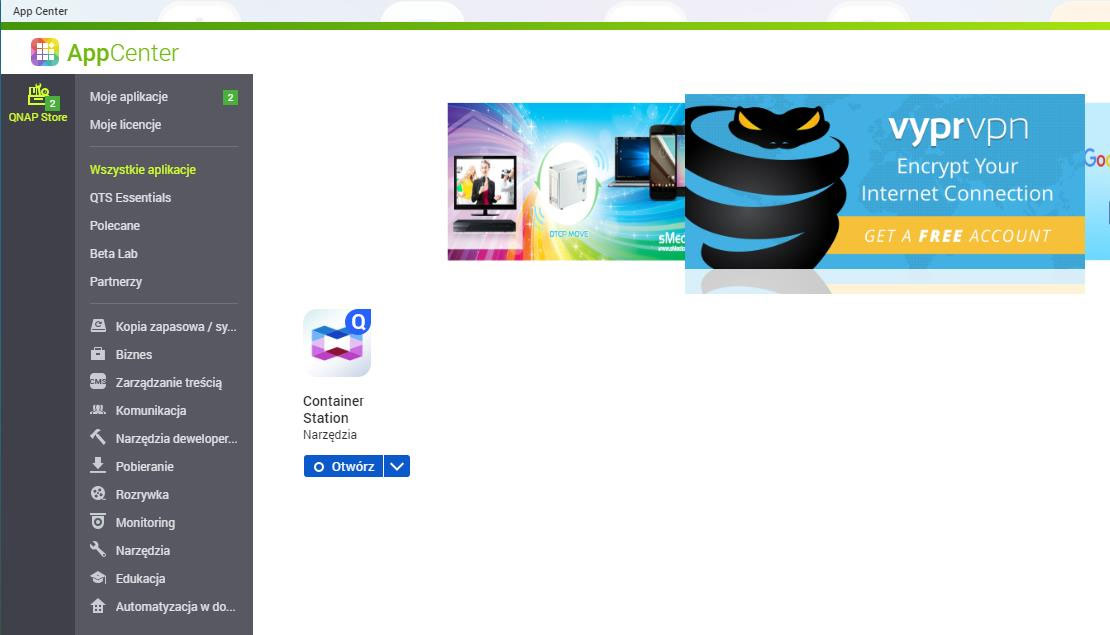

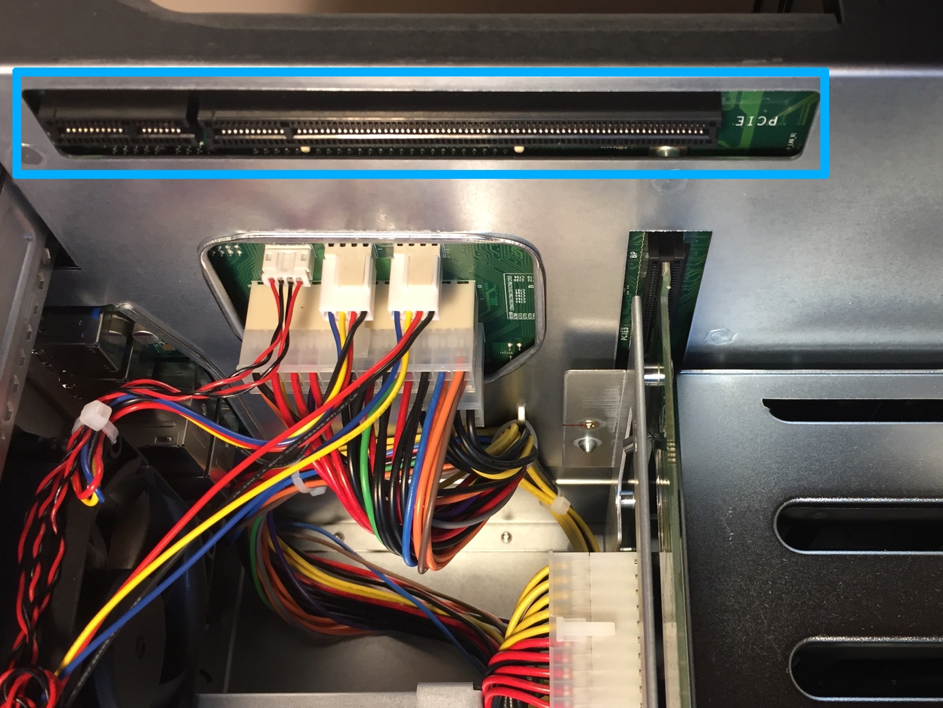

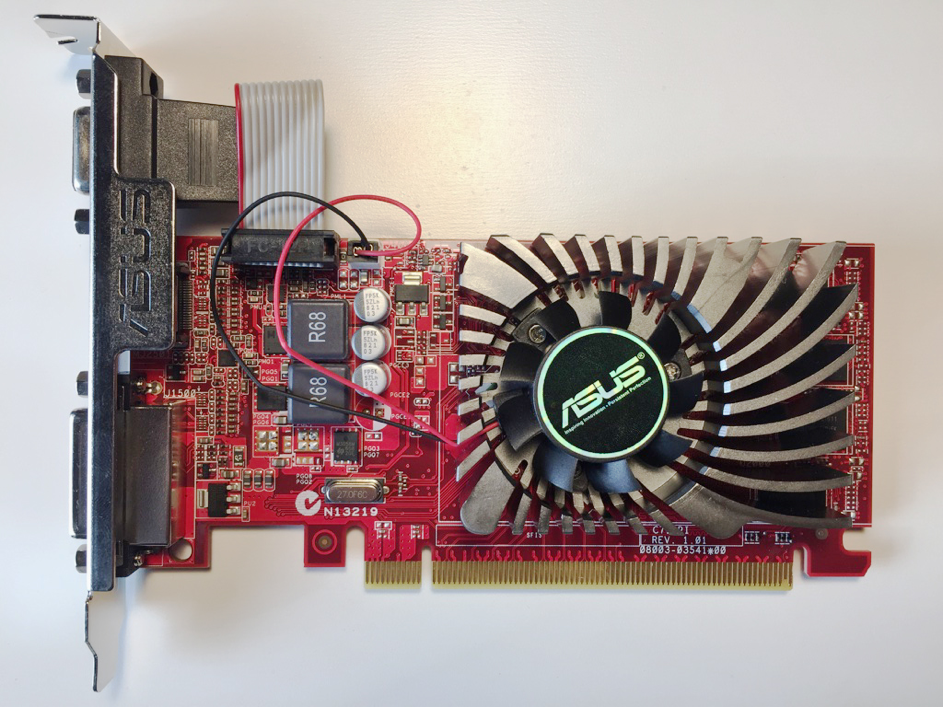

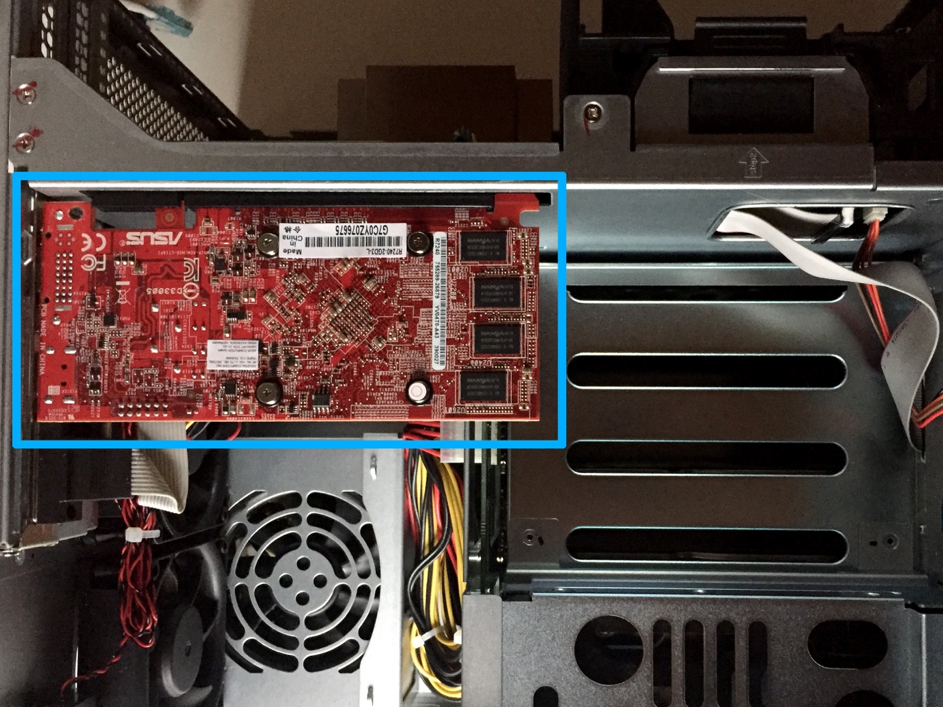

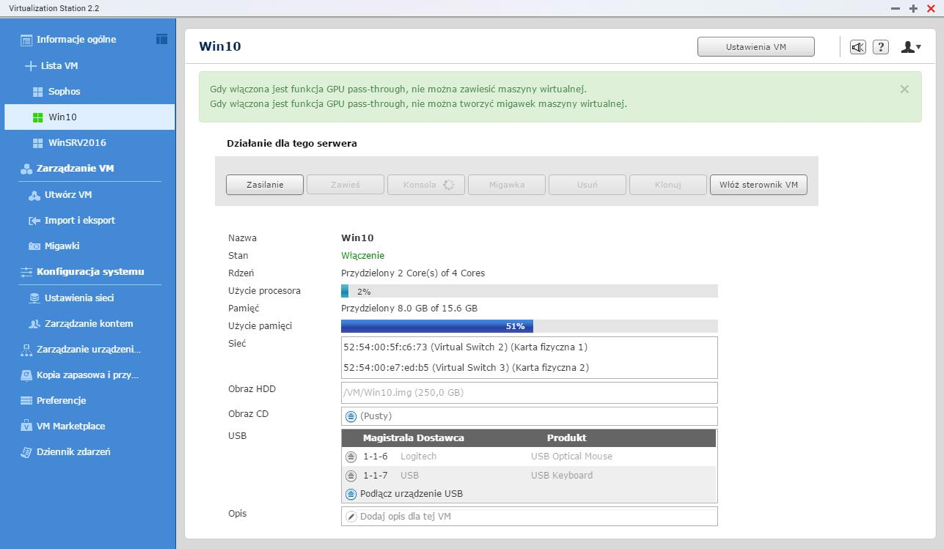

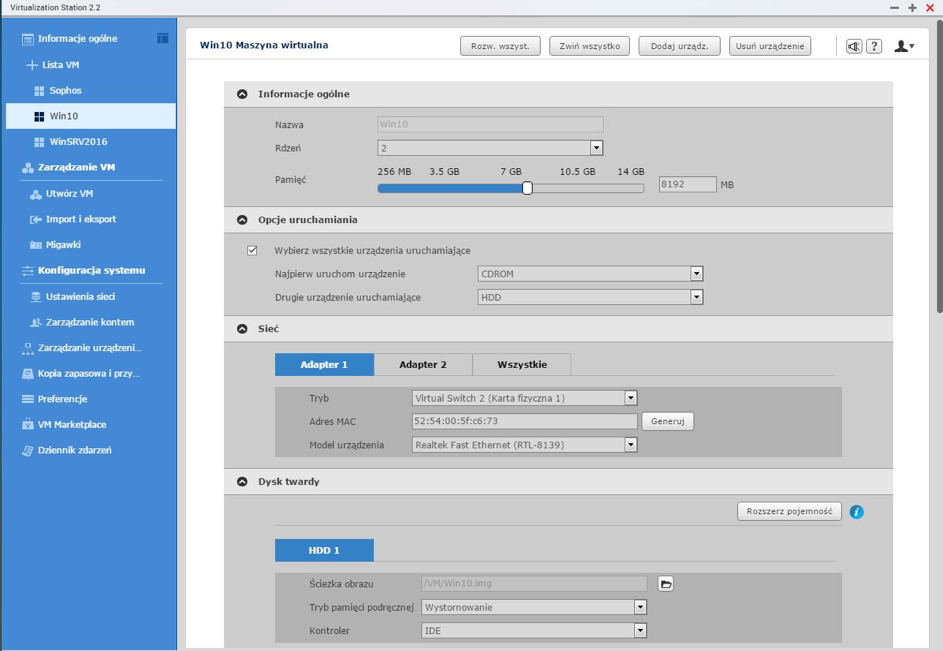

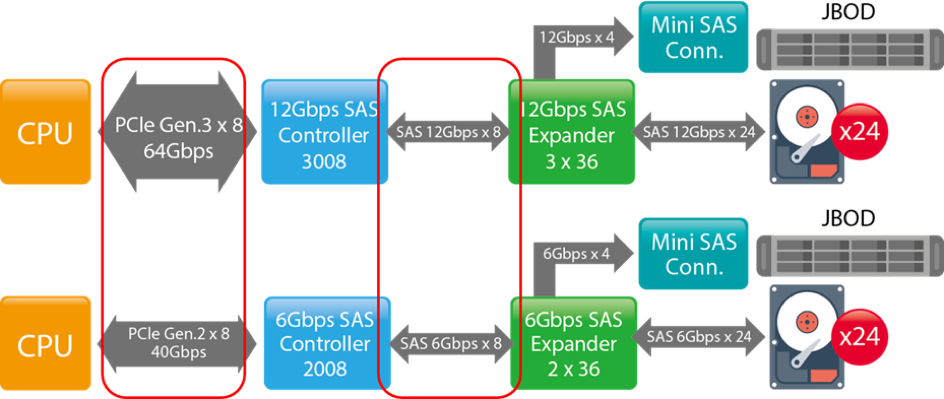

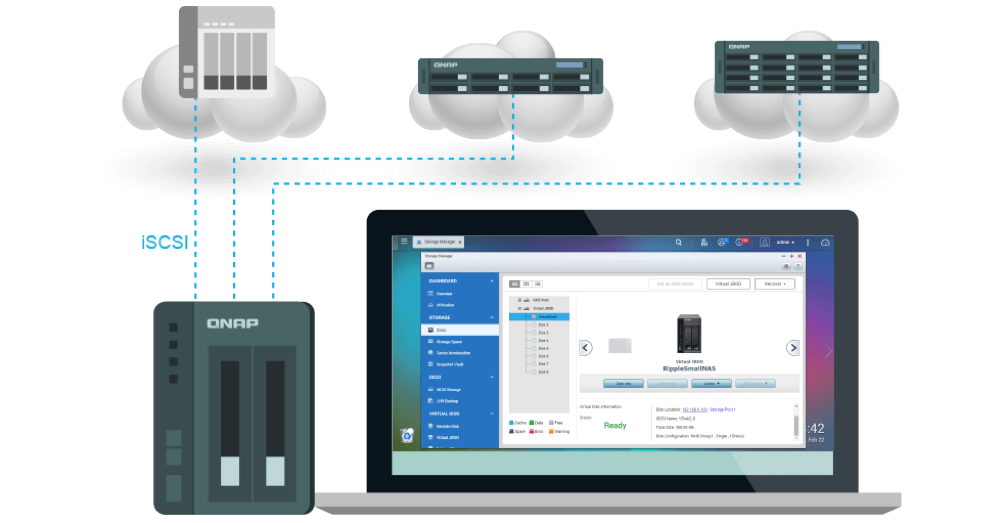

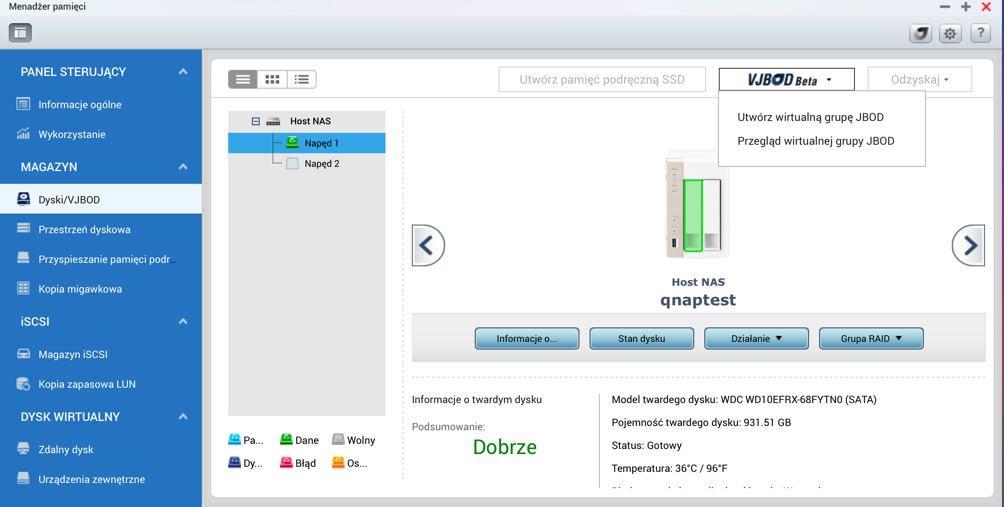

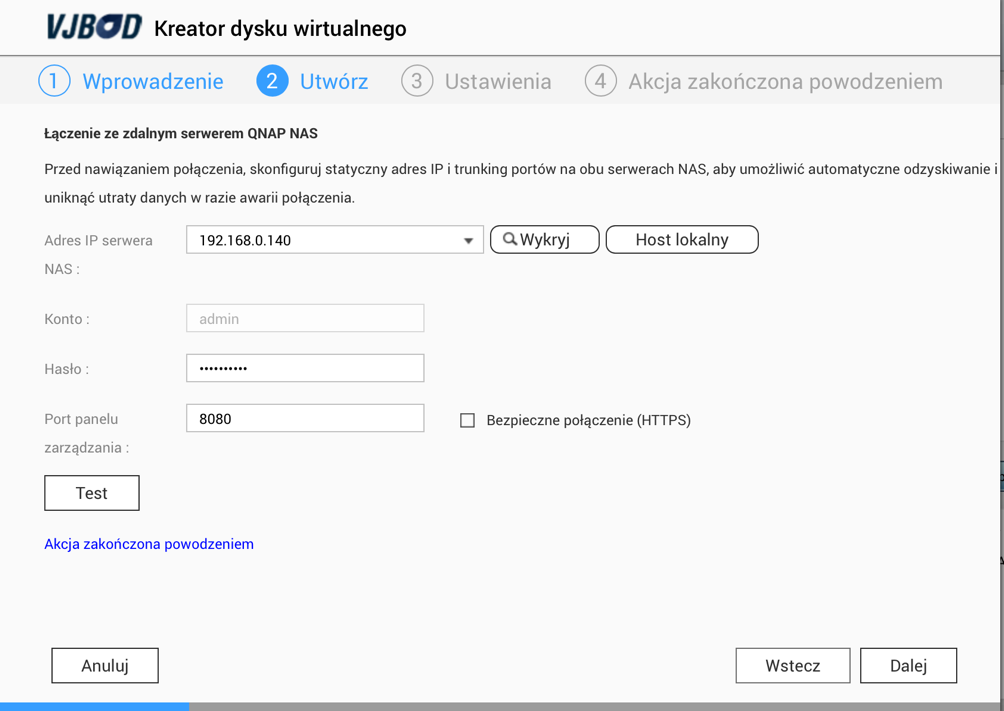

I czas na największą zmianę – seria Be wyposażona jest w port PCIe. Pozwala to na znaczne powiększenie funkcjonalności urządzenia, ponieważ mamy możliwość montażu kart rozszerzeń. Pełna lista obsługiwanych jest tutaj: https://www.qnap.com/pl-pl/compatibility/?model=312&category=11

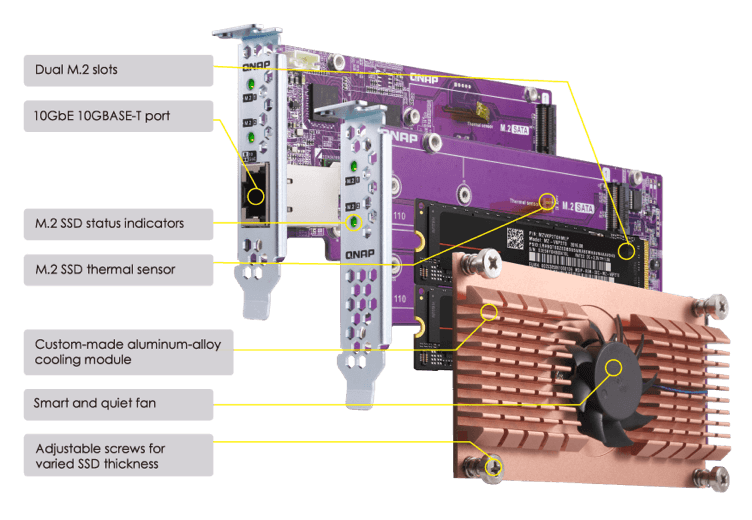

Warto zauważyć, że w ten sposób możemy podłączyć do naszego QNAPa kartę obsługującą interfejsy sieciowe 10GbE (RJ-45 lub SFP+) oraz kartę QM.2, która pozwala dodać 2 dyski M.2, a tym samym dwudyskowe urządzenie zmienić na czterodyskowe. W ten sposób możemy skorzystać z opcji SSD caching lub Qtier, a więc automatycznego pozycjonowania danych na dyskach.

Karty QM.2 występują w 4 wersjach:

- QM2-2S, obsługująca do 2 dysków M.2 SATA 2280

- QM2-2P, obsługująca do 2 dysków M.2 PCIe NVMe 22110 lub 2280

- QM2-2S10G1T, obsługująca do 2 dysków M.2 SATA 2280 oraz wyposażona w jeden port 10GbE Base-T,

- QM2-2P10G1T, obsługująca do 2 dysków M.2 PCIe NVMe 22110 lub 2280 oraz wyposażona w jeden port 10GbE Base-T.

Nowe modele oferują też 5 portów USB 3.0, w tym jeden z przodu obudowy, pozwalający na skonfigurowanie opcji szybkiego kopiowania danych pomiędzy pamięcią USB a QNAP’em. Podobnie jak poprzednik, seria TS-x53Be posiada 2 porty HDMI obsługujące rozdzielczość do 4K oraz 3 porty audio, 1 line-out oraz 2 wejściowe (na mikrofony), przy czym wszystkie są już w wersji mini jack 3,5 mm.

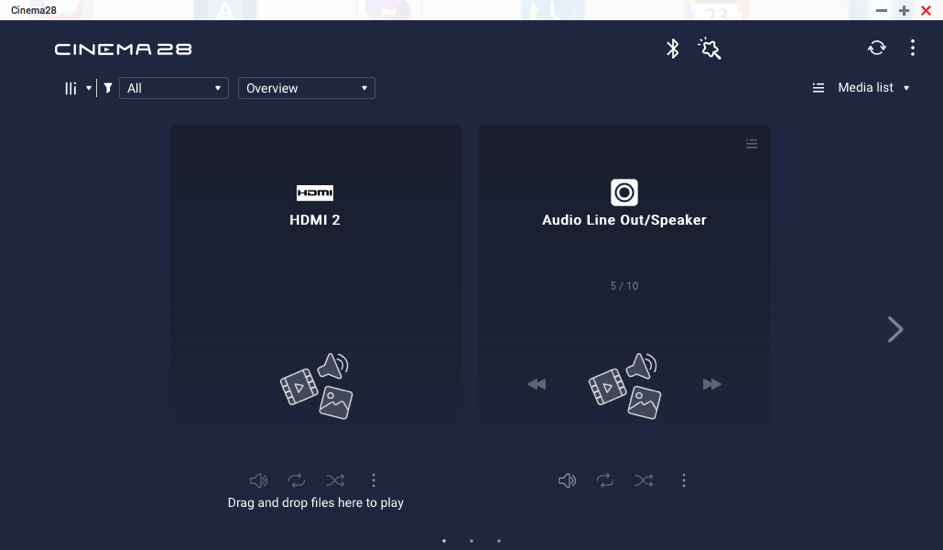

Warto tutaj nadmienić, że producent kładzie duży nacisk na rozwój funkcji multimedialnych urządzenia, zarówno pod kątem liczby portów wejścia/wyjścia, ale też rozwijając aplikacje do zarządzania i odtwarzania multimediów. Idealnym przykładem jest aplikacja Cinema28, która pozwala z poziomu systemu QTS odtwarzać multimedia na zewnętrznych odbiornikach przez AirPlay czy DLNA, ale też kierować strumień do odbiorników podłączonych właśnie przez HDMI czy audio-out.

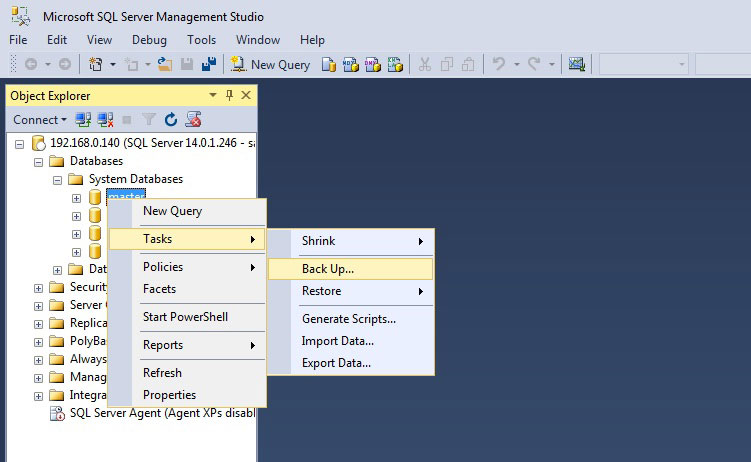

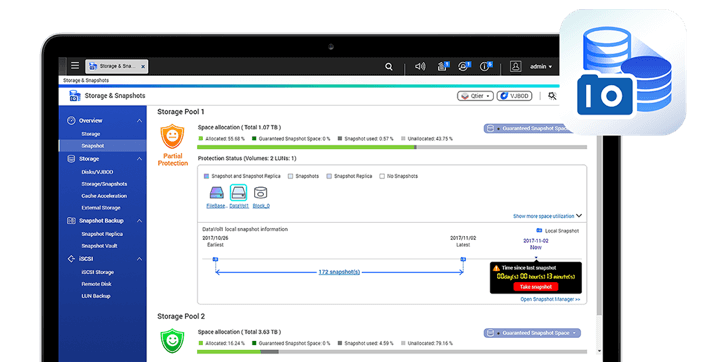

Przy opisie urządzenia nie sposób oczywiście napisać o jednej z najważniejszych funkcji, czyli mechanizmie wykonywania migawek. Migawki pomagają chronić dane poprzez rejestrację stanu i metadanych systemu NAS. W momencie wykonywania migawki system rejestruje, które bloki są wykorzystywane, a które nie, chroniąc te zapisane przed edycją.

W przypadku przypadkowej modyfikacji czy usunięcia pliku, możliwe jest jego przywrócenie z migawki (wersja pliku będzie dokładnie taka, jak w momencie tworzenia migawki). Migawki mogą obejmować całe woluminy, pojedyncze udziały sieciowe oraz jednostki LUN.

Daje to wysoki poziom bezpieczeństwa dla danych, chroniąc również przed zagrożeniami typu ransomware – nawet w przypadku zaszyfrowania danych na udostępnionym zasobie istnieje możliwość ich przywrócenia z migawki utworzonej wcześniej, przed infekcją.

Seria TS-x53Be to wydajne urządzenia w dobrej cenie, które warto stosować wszędzie tam, gdzie nie ma potrzeby lub możliwości stosowania urządzeń RACK, a jednocześnie potrzebne jest małe i wydajne rozwiązanie. Warto też pamiętać, że modele TS-253Be i TS-453Be to bardziej budżetowe wersje modeli z serii TS-x53B, która obejmuje też urządzenia z sześcioma zatokami na dyski twarde oraz dostępna jest w konfiguracji z 4GB lub 8GB RAM.

Urządzenia z literką „B” posiadają też porty USB-C QuickAccess, slot na kartę pamięci SD, przez co mogą być atrakcyjne np. dla fotografów czy osób zajmujących się nagrywaniem video, pilot zdalnego sterowania (RM-IR004) oraz mały wyświetlacz OLED prezentujący najważniejsze komunikaty systemu. Jeśli jednak te dodatkowe opcje nie są niezbędne, seria TS-x53Be powinna w zupełności wystarczyć.